都市景観をスキャンし3Dモデル構築する予想外の方法とは?

建物群から構成される都市景観の3Dモデリングは、様々なアプリケーションにおいて利用されているが、その利用は現時点では限定されており、より積極的な利用を促進するには、3Dモデル構築の省力化、自動化、低コスト化が求められる。最近、ジョージア工科大の研究グループが、都市景観をスキャンし、3Dモデル構築を行うあっと驚く意外な方法を考案している。本エントリでは、論文*1に従って、この手法の概要と、それによって将来可能になるであろうユースシーンについて紹介したい。本エントリで掲載する図表は本論文からの引用である。

| 【告知】@LunarModule7でつぶやいています。 興味のあるかたはフォローください。 |

GPSを使って街をスキャンする

GPSは30個程度の衛星のうち受信可能な位置にある衛星からの時刻情報、軌道情報などを受信し、衛星からの距離を測定、3次元位置を測位するものだ。4個のGPS衛星からの電波を受信できれば校正により精度を向上させる事ができる。

さて、仮に現在上空にあって信号が受信できるはずの衛星から信号が受信できないという状況を考えてみよう(実際にはGPS信号のS/N比の低下として現れる)。その際、考えられる原因は現在地とGPS衛星の間に何らかの障害物が存在するということだ。であるならば、現在位置を変えつつ複数のGPS衛星の信号受信状況を調べ、情報を統合してやれば、都市景観をスキャンして、3Dモデルとして再構築する事が可能となる。

図1は実際に高層ビルの遮蔽によりGPS信号のSN比が大きく減少する様子を示している。緑色ラインがSN比が低い部分を表し、ビルによるGPS信号の遮蔽がSN比の低下という形でクリアに検出できることが分かる。

|  |

|  |

| 図1:ビルの遮蔽によるGPS信号のSN比の低下 | |

本手法は次の主に2つのステージから構成される。

- 対象エリアにおける複数のビル群を検出するために密度マップ(density map)を作成する。

- 対象のビルの領域とサイズを推定し3Dモデルを構築する。

次にステップごとに処理過程を説明する。なお長文が嫌な人は下の方にある動画をチェックされたい。

密度マップ(density map)の作成

|

| 図2:BOAの上面図 |

|  |  |

| (a) | (b) | (c) |

| 図3:(a)BOA対象エリア,(b)生成された密度マップ,(c)ビル中心を検出するクラスタリング | ||

|  |

| 図4:密度マップと実際の写真比較 | |

3Dモデルの構築

|  |

| (a) | (b) |

|  |

| (c) | (d) |

| 図5:推定領域に含まれる複数のベクトルを用いて BOAビルの領域を推定する |

|

| |

| (a) | |

|  |

| (b) | (c) |

| 図6: ボクセルによる3Dモデル構築 | |

|  |  |

| 500 samples Half trip | 900 samples One trip | 1100 samples 1.5 trips |

|  |  |

| 2300 samples Two trips | 3200 samples 2.5 trips | 4000 samples Three trips |

| 対象地区 | 重心位置誤差(ft) | 領域誤差(%) | 実物高さ(ft) | 推定高さ(ft) | 高さ誤差 |

|---|---|---|---|---|---|

| BOA | 7.398 | 22.73 | 1023 | 862.80 | 15.65 |

| OAC | 22.59 | 22.20 | 820 | 705.32 | 13.98 |

まとめ

位置取得以外のGPSの利用方法としては、GPS信号が受信できない事に基づいて現在地は屋内であるということを推定する等の利用がなされているが、3Dモデルの構築に利用した例は本研究がほぼ初めてであり、アイデアがキラリと光る研究となっている。

高価なレーザー計測器ではなく、市販のGPSユニットでも実用的な精度の3Dモデルを自動生成することが可能である事から、将来的には不特定多数のユーザのGPS情報をクラウドで共有化することで、刻々と変化する都市景観をリアルタイムに3Dモデル化する事も可能になるだろう。精度は若干劣る部分があるが、GPSはパッシブに利用する事が可能であり、計測にユーザの能動的な操作を必要しない。完全に自動で位置情報が収集、共有されることで、3Dマップが生成されるのだ。きっと初めて足を踏み入れるような街であっても、しばらくみんなで街中を散策すれば3Dマップが構築できるようになるだろう。カーナビに搭載されているGPS情報を使う事ができれば、日本全国の都市の3Dマップを構築することも可能かも知れない。

『写真に基づく3D空間構築手法の到達点』や『Web上の膨大な写真からローマを1日で構築する方法』で紹介した画像ベースの構築手法と組み合わせれば、ビジュアル的にも実世界を忠実に反映した仮想空間を構築することができるはずだ。我々の生活する実空間と高度にリンクした寸分変わらぬ仮想世界が並行に存在する事が当たり前になったとき、社会はどう変わるのだろうか?

*1:Kihwan Kim, Jay Summet, Thad Starner, Daniel Ashbrook, Mrunal Kapade and Irfan Essa: "Localization and 3D reconstruction of urban scenes using GPS", Proceedings of the 2008 12th IEEE International Symposium on Wearable Computers (ISWC), pp.11-14, 2008.

*2:Y. Cheng. Mean shift, mode seeking, and clustering. IEEE Pattern Analysis and Machine Intelligence, 17(5):790.799, 1995.

日本経済新聞電子版はなぜこんなに高いのか?

前回のエントリでは、日本経済新聞 電子版の価格設定に関して、『予想どおりに不合理―行動経済学が明かす「あなたがそれを選ぶわけ」』に基づき、日経の狙いを考察した。元々エントリ化する予定も無かった話だが、望外にも多くのアクセスを頂いている。

実は、本書の第2章「需要と供給の誤謬」を見ると、なぜ日経が月額4,000円という高額な価格設定を行ったかについて、もう一つの理由が見えてくる。そこで、前回に引き続き、本書に基づき、高額な価格設定の狙いについて考えてみたい。月額4,000円という金額はたとえば産経NetViewの月額420円に比べて明らかに高い。なぜこんなにも高い価格となったのだろうか?*1

| 【告知】@LunarModule7でつぶやいています。 興味のあるかたはフォローください。 |

アンカリング

タヒチで生産される黒真珠は当初販路が無く需要もほとんどない代物であった。しかし、ダイヤモンド商ジェームズ・アセールは黒真珠のプロモーションに際し、旧友の宝石商ハリー・ウィンストンに、ニューヨーク五番街にある店舗のショーウィンドウに黒真珠をディスプレイし、法外に高い値段を付ける事を約束させた。そして、アセールは同時に豪華なグラビア雑誌に黒真珠の全面広告を出した。このプロモーションにより、誰も価値を知らなかった黒真珠は、あっという間にとんでもない高級品に変貌したそうだ。

雁の雛が生まれて最初に見る動くものを親だと思い込む刷り込み(インプリンティング)はよく知られている。一方、我々の価格に関する見方にも同様の傾向がある事が分かっている。アセールは、登場時から黒真珠を世界最高級の宝石として消費者に刷り込んだのだ(アンカリング)。そのため、以降ずっと黒真珠にはその価格がついてまわる事となった。我々は、一度新製品をある価格で買うと、後々まで同一ジャンルに属する製品に関しては、その価格に縛られる傾向がある。

ここで、アンカリングの効果を確かめる実験が紹介されている。この実験では不快な音に価格をつける評価を行っているが、その理由は不快な音に対する市場が存在せず、実験参加者が不快な音に対する既存のアンカーを有していないと期待されるからだ。

遭遇時のアンカリング

実験では、まず、2つのグループに対して3000Hzの高音からなる不快音を聞かせた直後に、第1のグループには10セント、第2のグループには90セントの報酬が支払われるとしたら、もう一度同じ不快音を聞いても良いか?との質問を行った。これは実はアンカリング用の質問で、これにより第1のグループには10セント、第2のグループには90セントという金額がアンカリングされることとなる。

ここで、「最低いくらもらえるならもう一度音を聞いても良いか?」と質問すると、第1のグループは平均33セント、第2のグループは平均73セントという回答となり、先ほどの質問において提示した金額が影響を及ぼしている事が分かる。それぞれのグループでは、不快音という価値の分からぬものに対して、それぞれ異なる価格をアンカリングされたのである。

未来の価格への影響

続いてホワイトノイズからなる不快音を聞かせた後、第1のグループ、第2のグループ双方に「もし50セント支払われるとしたら同じ音を聞いても良いか?」との質問を行った。今度は両方に50セントという金額をアンカリングしようと試みたわけだ。

ここで、「最低いくらもらえるならもう一度音を聞いても良いか?」と質問すると、第1のグループは第2のグループよりもはるかに低い金額を要求した。アンカリング用の提示は同じであるにもかかわらず、不快音に対する最初のアンカー(10セントもしくは90セント)が優勢だったことが分かる。これは、アンカーが現在の価格にも未来の価格にも影響を及ぼす事を示している。

最初のアンカーの重み

最後に今度は高低が激しく変動する不快音を聞かせた後、第1のグループには90セント、第2のグループには10セントの報酬が支払われるとしたらもう一度同じ音を聞いても良いか?との質問を行った。ここまで第1のグループは10-50-90セントという提示を受け、第2のグループは90-50-10セントという提示をうけてきたこととなる。最初のアンカーと直近のアンカーとどちらの方が優勢だろうか?

今までと同様に「最低いくらもらえるならもう一度音を聞いても良いか?」と質問すると、第1のグループはアンカーとして90セントが提示された後も低い報酬を受け入れた。一方で最初に90セントのアンカーを提示された第2のグループは、その後に違うアンカーが提示されたとしてもはるかに高い報酬を要求し続けた。これは、最初の決断がその後の決断に長い間影響する事を示している。最初に遭遇し判断に影響を与えたアンカーが、ずっと後までついてまわるのだ。

日本経済新聞 電子版の価格設定

さて、日本経済新聞 電子版は日本で初めてといって良い本格的な新聞電子配信サービスである。ここで仮に低い価格を付けてしまうと、この先、日本国内の新聞電子配信サービスにはその価格がアンカーとしてずっと影響を及ぼすことになる。国内随一の経済紙としての自負をもつ日経は最初に電子化に踏み出す以上、下手なアンカリングをするわけにはいかなかったのだ。

新聞社は長期的には電子化が避けられない事に気付いている。充分な体力があるうちに電子配信サービスによって充分な収益が得られる仕組みを構築できなければ、市場から淘汰される事に気付いている。一方で、現状の全国津々浦々までカバーする新聞紙配信インフラを一気に崩壊させるような性急な変化はリスクが大きすぎる。そこで彼らが狙ったのは、紙配信ビジネスを時間をかけて電子配信ビジネスへとゆるやかに変化させていくソフトランディングだ。それが「紙の新聞の部数に影響を与えないことを前提にした価格設定」であり、前回のエントリで扱った紙+電子版のセット配信へ消費者を誘導する仕掛けなのである。

将来的に電子配信ビジネスで新聞社を存続させようとした場合、配信価格は現状の購読料金に比べて極端には安くはできない。勿論、紙配信のための制作費やインフラ維持費は安くなる事が期待されるが、最初のアンカーを低く設定してしまうと、新聞業界全体の収益体質を弱体化させてしまうことになる(たとえば月額420円という価格設定ではとても新聞社は維持できそうにない)。そのため、彼らは高いと批判されることを承知の上で、4,000円という高額な価格設定を行ったのだ。先の事を考えて。

新聞記事のアンカー

ところが、現在Web上では多くの新聞記事を無料で購読する事ができる。言うなれば我々は新聞記事に対し無料というアンカーを保持している状況にある。このアンカーを保持する者にとって、4,000円という価格は異常に高くとても受け入れられるものではない。つまり、このアンカーが使われる事がないように、無料の記事とは全く異なったものだとユーザに認識させなければならない。

たとえば、スターバックスが登場した際には、ダンキンドーナツが安い価格でコーヒーを提供していた。人々はコーヒーの価格に対して、ダンキンドーナツの価格をアンカーとして所有していたはずであり、スターバックスは人々がコーヒーを飲むのに払っても良いと感じる価格よりも高い価格設定となっていた。

それでもスターバックスが成功したのは、価格ではなく雰囲気の面で他の店と一線を画すようにしていたからだ。ヨーロッパのコーヒーハウスの風情をもつ洒落た店内には、炒りたての高級豆の香りが立ちこめ、アーモンドクロワッサンやビスコッティなど見栄えのする軽食を並べた。そして、カフェアメリカーノ、カフェミスト、マキアート、フラペチーノなど高貴な名前の飲み物を売った。このように入店の体験が他とは全く異なったものとすることで、ダンキンドーナツのアンカーではなく、スターバックスが用意した新しいアンカーを利用するように仕向けたのである。

人々に、日経が他のWeb上で無料で読める新聞とは全く異なったものであることを認知させ、新たに用意したアンカーを利用させるための差別化が、日経の経済記事の全文配信であり、リコメンドやクリッピングからなるパーソナライズ機能である。しかし、パーソナライズ機能は他のWebサービスでも実現可能な範囲に留まっており、ユーザのアンカーを初期化するには力不足かも知れない。特に無料という価格設定は強い魔力を有しており*2、これに打ち勝つのは並大抵の事ではない。

一方、日本経済新聞は紙媒体の月ぎめ購読料(3,568円/4,383円)もアンカーとして利用させる事ができる。こちらのアンカーを使わせる事ができれば、4,000円という価格はリーズナブルに見える。今なら年配層を中心に、日本経済新聞のブランド力は強固に存在する。このアンカーを利用させるための一手が、月ぎめ購読料に+1,000円で電子版の購読権も付随する日経Wプランであるわけだ。

このように、日経は既存の紙媒体の購読者を維持しつつ、時間をかけて電子媒体に誘導する戦略をとっている。紙+電子媒体のセット販売を当面の本命に据え、既存の紙媒体顧客、紙流通インフラを当面の間維持することで、穏やかな電子媒体への移行を目論んでいるのだろう。そして、将来の収益構造を強固にする目的で、電子媒体に対し、高い価格のアンカリングを指向している。そこには長期的な視野に立った経営戦略が確かに存在する。

これが日経の目論み通り運べば、将来的に紙媒体の新聞がずっと縮小した後も、有料で高価な電子媒体の新聞記事が潤沢に供給される世界となるだろう。月ぎめ料金は最初のアンカーよりは市場原理に従い安価になるだろうが、新聞社を存続させるのに充分な収益を上げるぐらいの価格になるはずだ。

もちろん、目論み通りに事が運ぶかどうかは、別の話だけど*3。

参考文献

予想どおりに不合理―行動経済学が明かす「あなたがそれを選ぶわけ」

- 作者: ダンアリエリー,Dan Ariely,熊谷淳子

- 出版社/メーカー: 早川書房

- 発売日: 2008/11/21

- メディア: 単行本(ソフトカバー)

- 購入: 31人 クリック: 417回

- この商品を含むブログ (152件) を見る

日本経済新聞電子版の価格設定から透けて見える日経のホンネ

来る3月23日日本経済新聞 電子版が誕生するという。日本経済新聞の朝刊・夕刊の最終版が読めるのに加え、「電子版」の独自ニュースや解説記事を24時間配信するという。購読料金は宅配+電子版の日経Wプランが月極購読料+1,000円、電子版月極プランが4,000円という設定だ。

この価格設定、行動経済学の観点からすると大変興味深い。昨年のベストセラー『予想どおりに不合理―行動経済学が明かす「あなたがそれを選ぶわけ」』にまさにぴったりの事例が紹介されているので、未読の方の為に紹介したい。以下は本書の第1章「相対性の真相」のエッセンスを抽出し再構成したものである。この本は行動経済学の入門書として大変面白く書かれているので、未読の方には一読を強くお勧めする。

| 【告知】@LunarModule7でつぶやいています。 興味のあるかたはフォローください。 |

おとりによる選択行動の変化

あなたは経済新聞「エコノミスト」に興味がある。そこでWebサイトをチェックしてみると次の3つの購読プランが紹介されていた。あなたはどれを選択するだろうか。

- ウェブ版だけの購読($59)

- 印刷版だけの購読($125)

- 印刷版とウェブ版のセット購読($125)

この3つの選択肢を提示されると、多くの人が3番目の選択肢を選択するだろう。実際MITの学生100人に選択させると、次のような結果になった。

- ウェブ版だけの購読($59)──16人

- 印刷版だけの購読($125)──0人

- 印刷版とウェブ版のセット購読($125)──84人

MITの学生達は優秀なので、印刷版とウェブ版のセットの方が印刷版だけより得だと全員気がついている。さて、印刷版だけの選択肢を選んだ学生はいなかった訳だが、もし、印刷版だけの選択肢(以下「おとり」と呼ぶ)が無かったとすると、学生達は前と同じ判断をするだろうか?論理的に考えれば勿論同じ選択を行うはずだ。おとりは誰も選ばなかったのだから。しかし、結果は次のようになった。

- ウェブ版だけの購読($59)──68人

- 印刷版とウェブ版のセット購読($125)──32人

何が学生達の選択を変えたのか? 結果的に誰も選択しないおとりがあるだけで、セット購読の選択を行う者が増えるというのは明らかに不合理だ。しかし、これは予想どおりの結果なのである(この行動を系統的に予測することを可能にするのが行動経済学である)。

相対性による選択

実は人間はものごとを絶対的な基準で選択する事はほとんど無い。今回のエコノミストの場合、$59のウェブ版と$125の印刷版のどちらが得なのかは、なかなか判断ができない。しかし、$125の印刷版と$125のウェブ+印刷版のセットであるならば、後者が得なのは明白だ。この相対性の判断が多くの人がセット購読を選択した理由である。

まず左の図を見てもらいたい。2つの選択肢A、Bがあり、それぞれ違う特性で優れている。選択肢Aは特性1で優れており、選択肢Bは特性2で優れている。この2つの選択肢の優劣は簡単には付けられない状況だ。

しかしここに仮に特性1においてAよりも少しだけ劣ったA'という第三の選択肢(おとり)が用意された場合を考える(右図)。この選択肢はAよりも劣っているが、Aとよく似ているため比較を簡単にする作用がある。さらに、AがA'より優れているだけではなく、Bより優れているような印象を持たせる効果がある。相対性の判断は簡単に行えるため、我々は簡単に行える相対的な比較ばかりに注目する傾向がある。そして、判断が行いにくい絶対的な比較は、相対性の前に忘れられるのだ。

つまり、おとりA'を加える事で、Aとの相対的な比較が簡単に行えるようになり、結果として全体としてもAが優れているような印象が生まれる。結果としておとりのA'を誰も選ばなくても、Aが選択される可能性が高くなるわけだ。

この相対性による選択傾向を知っているマーケティング担当者は、自分が本当に選択させたい選択肢よりも、ちょっとだけ劣っているがよく似ているおとりの選択肢を用意する。そして人々はまんまとおとりに惑わされ、本来なら選ばなかったであろう選択を行うことになるのだ*1。

日本経済新聞 電子版の価格設定

さて、この相対性を念頭において、今回の日本経済新聞 電子版の価格設定を見てみよう。

- 日経Wプラン(宅配+電子版):月ぎめ購読料(3,568円/4,383円)+1,000円

- 電子版月ぎめプラン:月額4,000円

- 電子版登録会員(特ダネ+見出しのみ):無料

この選択肢を見て1番目と2番目では明らかに1番目の方がお得に見える*2。実際、3番目の無料の電子版登録会員でも良いのかも知れないが、月に4,000円以上払う価値が日本経済新聞にあるかどうかは難しい問題ですぐには答えが出ない。しかし、1番目と2番目なら断然1番目だ。こんな具合に、少し日経も読んでおいた方がよいだろうかなんて思っている人は、1番目の選択肢に誘導されることなるわけだ。

つまり、日本経済新聞社としては電子版はあくまでおとりであり、本命は1番目の選択肢を選択させて宅配の日経新聞の購読者数を増やすあるいは維持する事にあるのである。実際、日本経済新聞社の喜多恒雄社長は「紙の新聞の部数に影響を与えないことを前提にした価格設定」と説明している。

単純に日本経済新聞社の利益だけ考えると、1番目の選択肢と2番目の選択肢では、2番目の方が多いのかも知れない。それでも日本経済新聞社はあえて電子版ではなく、紙媒体の部数が伸びるような価格設定を行っている。少なくとも現時点においては電子版は本命の紙媒体の販促のためのおとりに過ぎない。Webに本腰を入れるとかかけ声は勇ましいが、ホンネは紙媒体なのである。すくなくとも現時点で紙媒体を購読している顧客が、紙媒体の購読を止めて電子版に移行する事は望んでいないはずだ。

このスタンスが過渡期の一時的なものなのか、それとも日本経済新聞がもつ簡単には変えようの無い特性なのか、答えが出るまでそう長い時間はかからないだろう。そう、彼らがいうように、時代の変化は彼らを待ってはくれないのだから。

参考文献

予想どおりに不合理―行動経済学が明かす「あなたがそれを選ぶわけ」

- 作者: ダンアリエリー,Dan Ariely,熊谷淳子

- 出版社/メーカー: 早川書房

- 発売日: 2008/11/21

- メディア: 単行本(ソフトカバー)

- 購入: 31人 クリック: 417回

- この商品を含むブログ (152件) を見る

低出力レーザーによる脂肪溶解処理がダイエットを無用にする

老若男女を問わずダイエットに悩む人は多いだろう。しかし、まもなくそれも過去の事となるかも知れない。既存の方法よりもずっと安全で低コストな脂肪除去が、まもなく身近で(もしかすると家庭でも)受けられるようになるだろう。もはやダイエットのために食事制限も、運動も必要ないのだ。

その新たな方法の名をゼロア(Zerona)という。右図は紹介動画のスナップショットだが、簡単に言えば、レーザー光を外部から照射する事で体内の脂肪を溶解させてしまうものだ。この今までの常識を覆す方法の原理はどうなっているのだろう?安全なのだろうか?費用は? その疑問に答えるのが本エントリの目的である。

| 【告知】Twitterはじめました。@LunarModule7です。 興味のあるかたはフォローくださいとしばらく宣伝。 |

ゼロア(Zerona)

ゼロア(Zerona)は既存の脂肪吸引とは大きく異なる。手で触れても安全なレベルの低出力レーザー(635nm, 10mW)を皮膚の上から40分間、2週間で合計6回(月・水・金・月・水・金など)にわたり照射するだけであり、もちろん痛みも酷い出血もない。米食品医薬品局(FDA: Food and Drug Administration)の認可を受けた*1医療機器である。

レーザー照射により、皮下脂肪細胞の細胞膜に一時的に極小の孔が空く。脂肪細胞内の液状化した脂肪がその孔から細胞外に流れ出すのである。脂肪はすぐに体外に排出されるので、2週間で見違えるほど痩せる事ができる。Telegraphが伝えたところによれば、FDAの調査において、患者の平均で3.64インチ(9.25cm)、ウェスト、ヒップ、太もものサイズの減少が確認されたと言う。中には9インチ(23cm)ダウンに成功した人もいるそうだ。既存の力業とも言える脂肪吸引とは異なり、脂肪細胞は正常なまま体内に残っているため安全性が高い。

ゼロア開発の元となった論文*2に従い、その原理と効果を見てみよう。

低出力レーザー治療

低出力レーザー治療は、治療対象となる組織に急激な温度上昇も組織構造に目に見える変化も生じない線量率を用いた治療と定義されている。低出力レーザは近年、創傷治癒や浮腫縮小、様々な病因の痛み除去など様々な場面での利用がなされてきている。論文ではレーザーを用いた脂肪除去法の確立のために、まずレーザーの医療応用に関する研究をサーベイし、着目すべき3つのファクタを抽出している。(1)可干渉性(コヒーレンス)、(2)波長、(3)出力の3点である。

コヒーレント光

量子力学に基づき、フレーリッヒ*3はエネルギーを注入すると、生体組織は分子のコヒーレント振動とマイクロ波信号の放射を引き起こすと予測した(ボース=アインシュタイン凝縮 Bose-Einstein condensation)。この信号が成長や修復、防御、そして有機体全体の機能を統合していると考えられている。この点において、生体組織は信号を放射し受信するアンテナだと言える。

しかしながら、低出力レーザー治療の効果においてコヒーレンスは重要な要素ではないことが分かっている*4 *5 *6。むしろコヒーレンスは、局所的な加熱を引き起こすスペックルパタンを生じさせる光の伝播と拡散に重要な役割を担っているようだ。

理想的な波長

バイオモジュレーション(biomodulation)を促進するため、630-640nmの波長が理想的であることが多くの研究によって示されている*7 *8 *9。またこの領域の波長は、線維芽細胞とケラチン生成細胞の増殖を促進させ、皮膚循環と微小循環を増加させ、瘢痕組織を減らす。630-640nmの波長は他の波長のレーザーに比べて少なくとも6-14%、創傷治癒において効果的である事が確認されている。

理想的な出力

高出力レーザーがもたらす最も大きな作用は加熱である。切除、切開、気化、凝固など多くの用途に利用されているが、これらは組織の破壊を伴い、その作用にはやや波長に依存する部分がある。

一方、低出力レーザーにおいては、波長とのより強い相関が見られる。照射されたレーザー光は受容体によって吸収されエネルギーに変換され、細胞間に伝達される。活性化された細胞は生化学的な反応を起こす。二次反応において重要な鍵となるイベントは、照射を受けた細胞の酸化還元状態が変化する事であるため、酸化還元状態を最適に保てば、反応を抑制する事が可能だ。

出力が2.91mW以下のレーザーは細胞の増殖を促進する一方、高すぎる出力だと効果が得られない事が知られている。増殖効果は照射時間を0.5分〜6分とした時に最も顕著に見られる。アルント・シュルツの法則として知られるように、弱い刺激は生命活動を喚起し、中度の刺激は生命活動を促進し、強度の刺激は生命活動を抑制し、最強度の刺激は生命活動を中止させる。実験室分析では、10mW出力のレーザーは100mW出力のレーザーに比べて細胞の有糸分裂に効果が見られた。

試験結果

低出力レーザーによるより安全で、短期間で、外傷の少ない脂肪除去手法の確立を行うために、前述の知見に基づき仮説を立て、次の実験を行った。

まず、ヒトの脂肪細胞を管内で培養し、レーザー光の照射実験を行った。照射により、脂肪細胞の細胞膜はその丸みを帯びた形を失い、細胞内部の脂肪が細胞膜に空いた孔から外部に流出することが確認された。その後細胞を培養すると、細胞は元の細胞膜構造を再生できることが確認された。細胞はレーザ照射後も生きており、成長することが可能なのだ。

次に、12人の健康的な女性に対してレーザーの照射実験を行った。深層脂肪へのレーザー光への浸透を図る目的で、チューメセント法と呼ばれる技術を適用した場合の比較も行っている。チューメセント法は水溶液を多量に脂肪層に浸潤させることで、脂肪吸引をスムーズに行うために利用されている技術である。

レーザ光の照射時間は2分、4分、6分の3パタンであり、表示波長635nm、最大出力10mWの低出力ダイオードレーザーを用いている。6インチの距離から2分、4分、6分照射した場合のエネルギーはそれぞれ1.2J/cm2、2.4J/cm2、3.6J/cm2となる。

次の5サンプルに対して、走査型電子顕微鏡による確認を行った結果を以下に示す(2分照射時は4分照射時と変化が見られなかったので割愛してある)。

- 患者腹部より採取された脂肪組織

- チューメセント法適用、レーザー照射無しで採取

- チューメセント法適用、4分間レーザー照射後採取

- チューメセント法適用、6分間レーザー照射後採取

- チューメセント法非適用、4分ないし6分間レーザー照射後採取

| 図1はチューメセント法適用、レーザー照射無しで採取したサンプルを走査型電子顕微鏡で確認したものを示している(x190)。ぶどうの房のような形状の輪郭が見て取れる。このサンプルはチューメセント法を適用したものであるが、レーザーの照射は受けていない。 |

| 図1 |

| 図2はチューメセント法適用、4分間レーザー照射後採取したものを走査型電子顕微鏡で確認したものである。4分間のレーザー照射により、部分的に脂肪細胞の崩壊が確認できる。しかし、一部の細胞は細胞膜の形状を保っている(図2上 x190)。脂肪細胞はその丸い形を失い、矢印で示す脂肪の粒子が脂肪細胞内部から外部に流出し、細胞間のスペースに広がっている(図2下 x130)。 |

| 図2 |

| 図3はチューメセント法適用、6分間レーザー照射後採取したものの走査型電子顕微鏡の確認結果である(x180 x190)。元の丸い脂肪細胞は全く見られない。液状化した脂肪は完全に細胞から離れ、細胞間の隙間に漂っている(矢印)。結合組織の一部には崩壊が見られるが、毛細血管や残りの間質腔等の他の構造はそのまま維持されている。 |

| 図3 |

| 図4はチューメセント法非適用で6分間レーザー照射後採取したサンプルの走査型電子顕微鏡による確認結果である(x450)。一部の脂肪細胞に崩壊が見られるが、その他の脂肪細胞はそのまま残っており、チューメセント法を適用した場合の4分間照射時とよく似ている。チューメセント法の適用はレーザー照射の効果を増大させる上で重要であるようだ。 |

| 図4 |

|  | 図5は40,000倍に拡大した照射を受けていない脂肪細胞を撮影したものである。レーザー照射を受けていない時には細胞膜は無傷で残っている。一方、図6が6分間レーザー照射を受けたサンプルを60,000倍に拡大したものである。細胞膜に一時的な孔(矢印)が空き、液化した脂肪(二重の矢印)が細胞の中から外へ流れ出しているのが分かる。 |

| 図5 | 図6 |

まとめると、レーザー照射を受けていない時には脂肪細胞は丸い形を保っているが、4分間のレーザー照射により脂肪細胞が部分的に崩壊し、80%の脂肪が液状化した。6分間のレーザー照射後には、ほとんど全ての脂肪細胞が崩壊し、脂肪を流出させている事が確認された。論文では透過型電子顕微鏡(TEM)による確認結果も示されているが、結果は上記と変わらないので割愛する。気になる方は元論文を参照されたい。

まとめ

低出力レーザーによる脂肪溶解法は、チューメセント法を併用して、波長635nm、出力10mWのレーザーの6分間の照射によって実現される。これにより、特に毛細血管のような間質を保ったままで、脂肪細胞の細胞膜に一時的な孔が穿たれる。4分間レーザー照射を受けると、80%の脂肪細胞が崩壊し、レーザー照射を6分間続けると99%が崩壊した。本手法は生体への負担が少なく、外科的な外傷も斑状出血も血腫も減らす事ができ、結果として患者の回復を早める。

レーザー照射によって細胞膜に開けられる孔は極小だが、チューメセント法を併用した際には、99%の脂肪が細胞の外に流出する。その場合でも、毛細血管やその他の間質は保たれている。本手法は既存の脂肪吸引法に比べて、より安全でより効果的な手法であると言える。

現在利用可能なゼロア施術装置は本論文の研究結果に基づいて設計されたもののようだが、基本的に635nmの波長の光を1,000Hzで変調して出力するだけに過ぎないように見える(ただし、照射時間などは論文とは異なっている)。最も普及している赤色のレーザーポインタの波長がちょうど635nmだ。レーザーポインタの出力はクラス2で1mW未満となっているため、出力不足を補う必要があるが、光学ドライブのピックアップ(〜500mW)よりもずっと小さい出力に過ぎない。操作もレーザー光が患部に当たるように調整するだけであり、手術費用は安く抑える事ができそうだ。

Telegraphによれば、英国では40分のレーザー照射を6回受ける手術一式で、£1,000(15万円)となっているようだ。15万円でお手軽にダイエットができるとするならば、受けたい人が大勢いるのでは無かろうか。日本でも早期に施術を受ける事が可能となる事を期待したい。

さて、最後に@drinami先生の忠告を引用してお開きとしたい。

レーザー脂肪溶解(ZERONA),単なる635nmの半導体レーザーを1kHzで変調してスキャンしてるだけだ http://ow.ly/13AZ8 動画 http://ow.ly/13B0N オマエら自作するなよ,絶対にだぞω

忠告に従わず、自作のレーザー装置でダイエットを試み、取り返しの付かない事態が発生したとしても当方は一切関知しないのでそのつもりで。

関連エントリ

*1:FDAのサイトを検索してみると、同じものかどうかは不明だが、Excalibur Light Therapy Systemが見つかる。635nmレーザーから構成されるシステムはLow Level Laser Therapy (LLLT)と名付けられているが、付記されている効能はtemporary relief of minor chronic neck and shoulder pain of musculoskeletal originとなっており、脂肪融解については触れられていないようだ。これは、既存の医療機器と同等の構造、機能を有する後発医療機器について簡易な手続きで登録できる510(k)による認可であるためだと思われる。

*2:Neira R, Arroyave J, Ramirez H, Ortiz CL, Solarte E, Sequeda F, Gutierrez MI.: Fat Liquefaction: Effect of Low-Level Laser Energy on Adipose Tissue, Plast Reconstr Surg., Vol.110, No.3, pp.912-922, 2002.

*3:Frohlich, H. Long-range coherence and energy storage in biological systems. Int. J. Quantum Chem. 2: 641, 1968.

*4:King, P. R. Low level laser therapy: A review. Lasers Med. Sci. 4: 141, 1989.

*5:Baxter, G. D., Bell, A. J., Allen, J. M., and Ravey, J. Low level laser therapy: Current clinical practice in Northern Ireland. Physiotherapy 77: 171, 1991.

*6:Baxter, G. D. Therapeutic Lasers: Theory and Practice. Edinburgh: Churchill Livingstone, 1994.

*7:Sroka, R., Fuchs, C., Schaffer, M., et al. Biomodulation effects on cell mitosis after laser irradiation using different wavelengths. Laser Surg. Med. Supplement 9: 6, 1997.

*8:van Breugel, H. H. F., and Bar, P. R. D. Power density and exposure time of He-Ne laser irradiation are more important than total energy dose in photo-biomodulation of human fibroblasts in vitro. Lasers Surg. Med. 12: 528, 1992.

*9:Al-Watban, F. A. H., and Zhang, X. Y. Comparison of the effects on wound healing using different lasers and wavelengths. Laser Ther. 8: 127, 1996.

論文の著者順に秘められた謎

論文には多くの著者名が並んでいる場合が多い。素粒子系の論文となると共著者が何百人と並ぶものも珍しくないが、共著論文の特徴についての調査結果によれば、最大の共著者数は2006年には2,512人に達したという。次がその論文だ*1。

総302ページの論文でなんと著者リストに21ページも使う。著者がちゃんとグループ化されてて、名前はappendixにある。この論文は別格だが、特に素粒子分野では共著者数が多くなることが多く、著者名はアルファベット順に並べられるのが通常なようだ。

こうした極端な例はともかく、数人の研究者の共著論文の著者名の並び順(authorship)には確固たる意味がある。最も重要なのは第一著者(first author)で、学位試験や大学人事などではfirst authorの論文しか評価しないと言う事も往々にしてある。ではその他の著者は、貢献順に並べればよいのかというと必ずしもそうでもなく、いろいろとお約束というモノがある。

そのあたりのお約束については研究室単位などで口伝で伝えられる場合が多いが、学外の論文に関しても、いろいろな事情に通じてくると大体の感覚というモノがつかめてくる。本エントリでは、PHD Comics: Author Listに論文の著者順に関して興味深い示唆がなされているので紹介したい。図はオリジナルを日本語訳したものである。

| 注意:この図は実在の研究者、教官、研究室、大学、研究機関、論文、学会、研究領域には一切関係のないフィクションであり、ジョークです*2。誰がなんと言ようとも。 |

- The first author (第一著者)

- プロジェクトに属する院生(博士後期課程)。図表を作った。

- The second author (第二著者)

- プロジェクトと何の関係もない院生。名前が載っているのは彼ないし彼女がグループミーティングに顔を出していたからだ(大抵はお菓子目当て)。

- The third author (第三著者)

- 実験を行い、解析・考察をして、論文全体を執筆した博士前期課程一回生。第三著者がフェアな位置だと考えている。

- The middle authors (中間に位置する著者達)

- 誰も実際には気に留めない著者名。学部生や技官のための場所。

- The second-to-last author (最後から2番目の著者)

- The last author (最後の著者)

- 一番偉い人。論文を読んですらいないが、プロジェクト推進に必要な予算を獲得した。また彼の有名な名前が著者名として記載されている事で論文が通るという面もある。

この話、中の人にとっては笑えない話であり、外の人にはなにやら分からないというワケで、結局誰にとってもおもしろくない話だと後になって気付いた。ちなみに論文の共著者に関係のない人間を加える事は純然たる不正行為であり、gift authorshipと呼ばれるようだ。Wikipediaによれば、露・モスクワの有機元素化合物研究所(IOC)の研究員ユーリ・ストルチコフが10年間で948本もの論文の共著になっており、IOCの施設を利用の見返りとしてIOCの人間を共著者に入れるのが慣習化していたらしい。また、ストルチコフはこの件でイグノーベル賞を受賞したそうだ*3。

関連エントリ

| 【告知】Twitterはじめました。@LunarModule7です。 興味のあるかたはフォローくださいとしばらく宣伝。 |

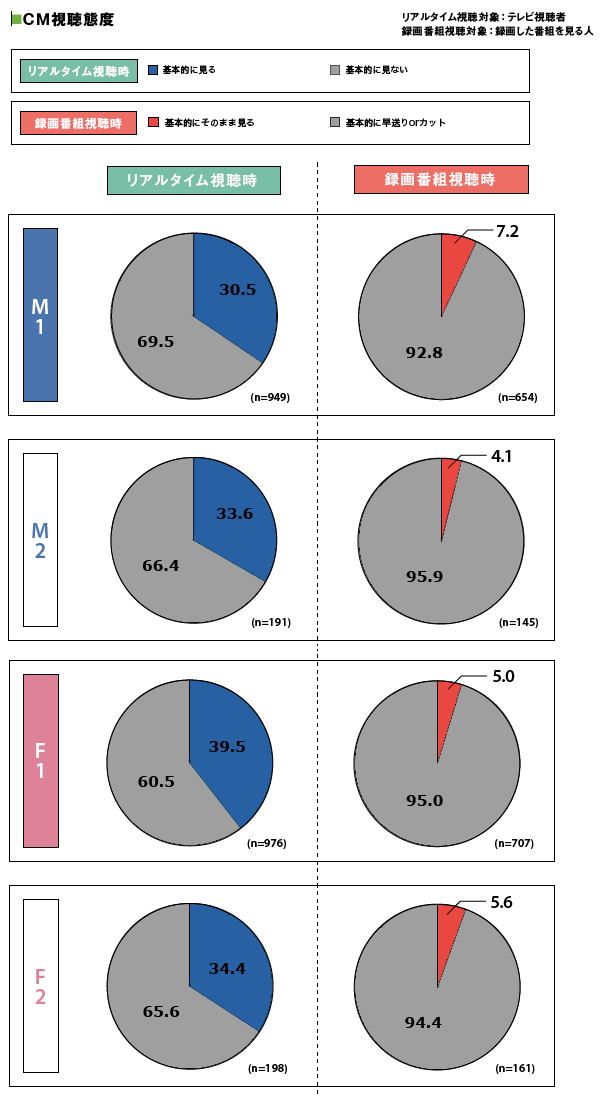

我田引水なM1・F1総研の分析レポートを容赦なく添削してみた

M1・F1総研は『若者におけるテレビの存在価値の考察』というレポートを発表し、若者のテレビやテレビCMの視聴実態について調査・分析を行い、M2・F2と比べると、実はM1・F1はテレビへの依存度が高いと結論づけている*1。CNET JAPANでも若者は“テレビ離れ”していない--M1・F1総研の調査で明らかに:マーケティング

ところで、M1・F1総研は電通とリクルートが共同設立したプロモーション会社であるメディア・シェイカーズの一部門である。今回の分析においても、『CMを見ないM1・F1は圧倒的に少数派』『テレビCMはしっかり見ていて、テレビCMの影響度は強い』と、親会社の収益源であるテレビCMの有効性を声高に謳っている(内容のハイライト(PDFファイル 260KB)、分析レポートVol.12 ダイジェスト編(PDFファイル 2.9MB))。

テレビが見られている事についてはそれなりに妥当な結論であると思うが、CMの効果に関しては疑問を感じざるを得ない。なぜこのような結論に至ったのだろうか?

| 【告知】Twitterはじめました。@LunarModule7です。 興味のあるかたはフォローくださいとしばらく宣伝。 |

奇妙な結論が導出されるカラクリ

ダイジェスト編13ページにその分析が掲載されている。ハイライト版にはリアルタイム視聴時のグラフしか上がっていないが、ダイジェスト版には録画視聴時のデータも掲載されている。

リアルタイム視聴時の設問は次の通りだ(F1回答/M1回答)。

■ だいたいしっかり見る(7.9%/8.4%)

■ 見ないこともあるが、しっかり見ることが多い(26.6%/31.1%)

■ 見ないことが多いが、たまにしっかり見る(47.8%/50.0%)

■ ほとんど見ない(17.7%/10.5%)

この4つの選択肢のうち、なんと3つに「しっかり」という単語が含まれており、それらをCMをしっかり見る人と集計して、『しっかり見る計:82.3%』『しっかり見る計89.5%』『M1・F1ともに、CMを見ない人は1割台にとどまる。(リアルタイム視聴時)。』という奇妙な結論を導き出している(たまになんとなくCMを見る人はいったいどの選択肢を選べばよいのだろうか)。しかし、この選択肢を見ると、基本的にCMを見ると回答しているのは好意的に見てせいぜい前者2つで、後者2つは基本的にCMを見ないと捉える方が妥当だろう。質問の設計段階においてCMを見る割合が多くなる結論が得られるように選択肢が意図的に設定され、期待する結論が導出されている訳だ。調査設計の観点から見てあまりに酷い。

一方、録画番組視聴時の設問は次の通りだ。

■ 早送りをしないで、そのまま見ることが多い(7.2%/5.0%)

■ 早送りをするが、気になるCMは止めて見ることがある(21.1%/20.5%)

■ 早送りをしてCMを止めて見ることはほとんど無い(57.3%/65.8%)

■ 録画の時点でCMはカットすることが多い(14.4%/8.8%)

この4つの選択肢において、前者2つがCMを「しっかり見る」とされ、『録画番組視聴時の「テレビCMをしっかり見る計」の割合は、M1が28.3%、F1が25.5%。』という結論を導き出している。しかし、選択肢を素直に解釈するのであれば、CMをしっかり見ているのは一番最初の選択肢ひとつのみで、残りは早送りかカットが基本という事だろう。録画機器の普及により、テレビCM効果が減少しているのではないかという批判に常に晒されている広告業界としては、CMの効果が充分にあるという事を訴えたかったのだろうが、やり方が姑息だと言わざるを得ない。

添削してみる

そこで、次のように選択肢を整理してグラフを書き直してみた。特に録画視聴時においてはテレビCMは悲惨なほど見られていない事が一目瞭然だ。

- リアルタイム視聴時

- ■ 基本的に見る

- だいたいしっかり見る

- 見ないこともあるが、しっかり見ることが多い

- ■ 基本的に見ない

- 見ないことが多いが、たまにしっかり見る

- ほとんど見ない

- ■ 基本的に見る

- 録画番組視聴時

- ■ 基本的にそのまま見る。

- 早送りをしないで、そのまま見ることが多い

- ■ 基本的に早送りorカット

- 早送りをするが、気になるCMは止めて見ることがある

- 早送りをしてCMを止めて見ることはほとんど無い

- 録画の時点でCMはカットすることが多い

- ■ 基本的にそのまま見る。

結論も以下のように修正することが妥当であろう。

↓修正

結論として、テレビCMはほとんど見られていないので、広告主はテレビCMの費用対効果についてしっかりと精査する必要があると言える。もちろんテレビは今でも影響力があるメディアであることは確かであり、テレビCMの効果は他のメディアと比べてまだまだ大きいはずだ。しかしその効果が低下しつつあるのは確かだ。

以前、『花粉症で1日約6,000円の損失って頭悪すぎでは?』で取り上げたコンタック総合研究所の調査のように、中立でない企業や団体が公開する調査結果は、それらの企業や団体の利益に繋がるように、意図的にその印象が歪められて伝えられる場合がある。バイアスのかかった調査レポートは注意深く読まなければならない。

追記

本エントリは@bugbird氏とのTwitter上のやり取りが元になっている。有益なご指摘に感謝したい。@bugbird氏の方でも恣意を見落とさないように!というエントリで本件を取り上げられており、リンクもいただいている。重ねて感謝申し上げます。

Web上の膨大な写真からローマを1日で構築する方法

前回、『写真に基づく3D空間構築手法の到達点』としてバラバラの写真から3D空間を構築する手法について取り上げた。コメントで言及された人もおられたが、MicrosoftはPhotosynthとして、同様にStructure-from-Motion (SfM)を用いて写真をつなぎ合わせ、インタラクティブにブラウズできるPhotosynthを公開している。

現在、研究レベルではWeb上にアップされた不特定多数のユーザによる膨大な写真から街一つを再現するプロジェクトが推進されている。その名も"Building Rome in a Day"(ローマを一日にして成す)だ。下の動画はFlickr検索された画像から生成された3Dモデルを示している。本エントリでは、論文*1に基づき、その構築手法の概要を紹介する。本エントリ中の動画像は論文及びプロジェクトページからの引用である。

| 【告知】Twitterはじめました。@LunarModule7です。 興味のあるかたはフォローくださいとしばらく宣伝。 |

ネット上には多くのユーザが撮影した写真が無数にアップされている。たとえば、Flickrにおいて"Rome"と検索すると200万枚以上の写真がヒットする。数百、数千の視点から撮影された千差万別の写真がアップされており、たとえば有名な観光スポットであるトレビの泉単体だけ数えても検索結果は5万枚に上る。

本研究のシステムでは、これらの写真にStructure-from-Motion (SfM)を適用し、被写体のオブジェクトやシーンの形状、及びカメラの動きを復元し、街全体を構築している。本研究では、1日以内に15万枚に及ぶ画像を処理しているが、これは他の先行研究に比べて1桁ないし2桁大きい値だ。

先行研究では、厳密にキャリブレーションされたカメラで撮影され、GPSや慣性航法ユニットのデータが付与された写真を利用する事によって、解析処理を単純化している。しかし、Webから収集した写真は、多様なカメラにより撮影され、照明条件もバラバラで、地理情報は付与されていないか極めて限られている。そして多くの場合、カメラキャリブレーション情報も手に入らない。このような雑多なデータに対してSfMを適用することは難しいチャレンジとなる。また、膨大なデータを扱うためには最大限処理を並列化させる必要がある。

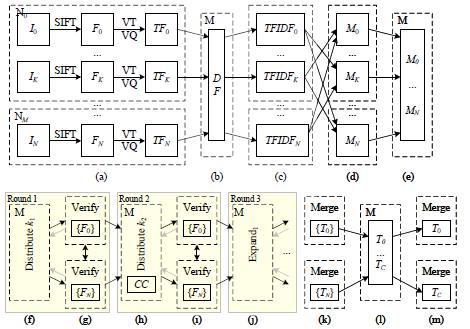

前処理・特徴抽出

処理対象となる画像は中央ノードから各分散ノードに処理能力に応じて配分される。中央ファイルサーバが必要になるのは全てのプロセスにおいてこの時点だけである。各分散ノードにおいて、画像の可読性チェック、EXIFタグ抽出、(もし記録されていれば)焦点距離値抽出、200万画素以上の画像の縮小処理が成される。そして、SIFT(Scale-Invariant Feature Transform)特徴量*2の抽出が行われる。SIFTは画像の回転、拡縮、照明条件等に頑強な特徴量であり、画像のマッチングやオブジェクト認識等に広く利用されるアルゴリズムである。

画像マッチング

SIFT特徴量のマッチングにはANN library*3が利用できるが、こうしたマッチングと検証を100,000画像の5,000,000,000ペアに対して適用しようとすると、500コアのCPUをフルに使っても11.5日かかる計算になる。また、"Rome"と言うような広いタグが付与される写真は実際はほとんど相互に関連しない。そこでマッチング処理を効率に行うために、本研究では多段階のパイプライン処理を実装している。次の図はその概要を示したものだ。

N枚の画像がM個の分散処理ノードに配付され、次の順序で処理される。例によって詳細は元論文を参照されたい。

- SIFT特徴量の抽出を行い、k-means treeに格納して量子化する。検索で一般的に利用されるTFIDF法を利用するために、各画像の全ての特徴量に対しTF(term frequency)のカウントを行う。

- 全ての特徴量に対しそれを有する画像、DF(document frequency)をカウントする。

- 各ノードでTFIDF行列の計算を行い、その結果を全ノードにブロードキャストする。

- 他ノードの結果に基づき、各ノードで並列してTFIDFベクトル行列の積を計算する。

- TFベースの近傍検索により、それぞれの画像に対して類似度が最も高くなる上位k1+k2の候補画像を導出する。

- 次に候補画像の検証を行うために、各ノードに必要な画像を移動させる。画像が全て単一のノードに集まっているのなら話は単純だが、画像は各ノードに分散されているので工夫する必要があるが、計算量と効果との兼ね合いから、結局シンプルなgreedy bin-packingアルゴリズムによって、センターノードが上位k1の画像を優先的に各ノードに検証画像を割り当てている。

- 各ノードにおけるSIFT特徴量の光度マッチングに加え、カメラキャリブレーション情報が利用できる場合には基本行列(essential matrix)/基礎行列(fundamental matrix)の推定を行う。ここでの推定結果は後の幾何学的推定プロセスにおいて利用される。

- ここでは、画像間の特徴量のマッチングを表したmatch graphを用いる。match graphでは、2つの画像間にマッチする特徴量が存在すればその画像間がエッジで繋がれる。画像に基づく再構築を行うために、match graphからなるべく多くの関連画像を結合させた結合コンポーネント(CC)を抽出する事を考える。そこで、CCのマージを行うために、各画像に対して次位k2の画像を確認し、2つのCCにまたがることが確認されれば、その画像を組み入れてその2つのCCを連結させる。こうしてCCはどんどんマージされていく。

得られたmatch graphをより充実させるためにクエリ拡張(query expansion)として知られる検索手法を利用する。クエリ拡張は初期キーワードによって得られた検索結果に基づいた再検索によって、より良い検索結果を得ようとするアプローチだ。match graphにおいてAがB、BがCにマッチしているならば、AがCにマッチするかどうか確認する事で、画像間の結合度を密にしていく。

- 再度、画像間のマッチング確認を行う。

- このクエリ拡張、マッチング確認処理を4回繰り返す。次の図はmatch graphがCCのマージ、4回のクエリ拡張によって拡張されている様子を示している。match graphの密度が大きく向上している事が分かるだろう。一番右のskeltal setは最終match graphの骨組みのみを示したものだ(後述)。

トラック生成

最終段階では全てのマッチング情報対から画像間で一貫性のあるトラックを生成する事である。マッチング情報は各ノードに分散して配置されているので、このプロセスは2段階に分けて行われる(パイプライン図の(k)〜(m))。まず各ノードでローカルに利用可能な情報だけを用いてトラックが生成される。データはマスターノードに集められて、全てのノードにブロードキャストされる。各CCのトラックは独立して計算され、統合時に矛盾箇所の整理が行われる。

トラックが生成されると特徴点の2D座標を抽出すると共に、後に3Dレンダリングに利用するための特徴点のピクセルカラーを抽出する。これらは各CCごとに並列して処理され、センターノードに集められて、ブロードキャストされる。

幾何学的推定

トラックが生成されれば、各CCに対しStructure-from-Motion (SfM)を適用してカメラ位置と3D座標の特定を行う。効率的に計算を行うために、まずskeltal set抽出手法*4を用いて骨組みを抽出し、それに対してSfMを適用、ベースモデルを構築後、残りの画像を追加していくと言うアプローチをとる。

適用結果

ローマ(Rome)

Flickrにおいて"Rome"もしくは"Roma"タグが付けられた150,000枚の写真をデータセットとして利用している。496コアでマッチングと再構成に21時間かかっている。マッチングの結果、画像はローマの有名なランドマークに対応するいくつかのグループに分類されている。コロッセオ(Colosseum)、サン・ピエトロ寺院(St. Peter's Basilica)、トレビの泉(Building Rome in a Day)、パンテオン(Pantheon)などを見つける事ができる。コミュニティの写真コレクションを使う事の利点の一つは非常に多様な視点からの写真を利用する事ができる点だ。

|  |  |  |

| Colosseum: 2,097 images, 819,242 points | Trevi Fountain: 1,935 images, 1,055,153 points | ||

|  |  |  |

| Pantheon: 1,032 images, 530,076 points | Hall of Maps: 275 images, 230,182 points | ||

ヴェネツィア(Venice)

ヴェネツィアのデータセットはこれまでの中で最も大きいものである。496コアでマッチングに27時間、3D再構築に38時間かかっている。大運河(Grand Canal)、サンマルコ広場(San Marco square)、ドゥカーレ宮殿(Doge's Palace)の3つの大きなコンポーネントが生成されている。サンマルコ広場は現時点で最も大きな再構成モデルであり、14,000枚の画像と450万以上の3Dポイントから構成されている。

|  |  |  |

| San Marco Square: 13,699 images, 4,515,157 points | |||

|  |  |  |

| Grand Canal: 3,272 images, 561,389 points | |||

ドゥブロブニク(Dubrovnik)

実験時においてFlickrには世界遺産でもあるドゥブロブニクの写真が僅か58,000枚しか無かった。それでもこの街全体を再現する事に成功している。マッチングは352コアで僅か5時間で完了し、最大かつ最も興味深いコンポーネントは古い町全体を包括している。再構成時間は17.5時間とローマのケースに比べて長くかかっている。これはデータセットがどのように構成されているかに依存している。ローマの場合データセットは基本的に巨大でシンプルなランドマークに集中していたが、ドゥブロブニクの場合は複雑な路地等を含む街全体を包括するように分散していたからだ。次に4視点からの写真と生成された対応する画像を示す。街全体をストリート上も屋根の上からも再現していることに注目して欲しい。再現モデルは4,585枚の画像と11,839,682個の特徴を有する2,662,981の3Dポイントから構成されている。

|  |  |  |

|  |  |  |

| The old city of Dubrovnik, 4,619 images, 3,485,717 points | |||

処理時間

次に上記の3つのデータセットに対する処理時間を示す。数十万枚に上るデータセットに基づく3Dモデルの再構築が数日のオーダーで完成している事が分かる。

| Time (hrs) | ||||||||

|---|---|---|---|---|---|---|---|---|

| Data set | Images | Cores | Registered | Pairs verified | Pairs found | Matching | Skeletal sets | Reconstruction |

| Rome | 150,000 | 496 | 36,658 | 8,825,256 | 2,712,301 | 13 | 1 | 7 |

| Venice | 250,000 | 496 | 47,925 | 35,465,029 | 6,119,207 | 27 | 21.5 | 16.5 |

| Dubrovnik | 57,845 | 352 | 11,868 | 2,658,264 | 498,982 | 5 | 1 | 16.5 |

まとめ

以上に紹介したように、Flickrに代表される写真共有サービスに、世界中の様々な人が、自分たちのカメラで撮影した、撮影日時も、季節も、天候も、場所も、カメラ位置も、方向も、カメラも、レンズ性能も、照明効果も異なる全くバラバラな写真から、数日で街全体を再構築する事が可能になりつつある。

今はまだ何となく街の形が分かる程度だが、アップされるメディアの質・量が増加し、手法が洗練され、利用できるコンピューティングパワーが増加すれば、よりリアルな3Dモデルを構築する事ができるようになるだろう。かけがえのない一瞬を留め置くカメラが発明されてから2世紀──そして今や、その一瞬を再構築し追体験できる段階に進みつつあるのだ。

関連エントリ

*1:Sameer Agarwal, Noah Snavely, Ian Simon, Steven M. Seitz and Richard Szeliski: International Conference on Computer Vision, 2009, Kyoto, Japan.

*2:D. Lowe. Distinctive image features from scale-invariant keypoints. IJCV, 60(2):91.110, 2004.

*3:S. Arya, D. Mount, N. Netanyahu, R. Silverman, and A. Wu. An optimal algorithm for approximate nearest neighbor searching fixed dimensions. JACM, 45(6):891.923, 1998.

*4:N. Snavely, S. M. Seitz, and R. Szeliski. Skeletal graphs for efficient structure from motion. In CVPR, pages 1.8, 2008.